Nein, hier geht es definitiv nicht um Investments selbst, dementsprechend gibt es hier keine Empfehlung für oder gegen ein Produkt – zumindest in finanzieller Hinsicht.

Worum es mir geht, ist der technische oder vielmehr sicherheitstechnische Aspekt – zumindest in dem Umfang, wie ich es mit gefährlichem Halbwissen in Sachen Security bewerten kann.

Die E-Mail

Seit einer Weile habe ich Investmentsparen bei meiner lokalen Bank bzw. vielmehr bei UnionInvestment. Bis vor kurzem war das Teil auch recht ruhig, bis folgende Mail eintrudelte:

Kopf macht „bee-doo bee-doo“:

Mails werden bei mir grundsätzlich als Nur-Text angezeigt, was mehr als nützlich ist, um Spam/Scam/Phishing zu erkennen, also mal ein Blick auf alles klickbare:

- Absendername passt nicht zur Absender-Mailadresse

- Domain der eingebetteten Bilder passen nicht zur Absender-Domain

- Hyperlinks passen nicht zur Absender-Domain

- Rückfragen-Mailadresse passt nicht zur Absender-Mailadresse

- Die Mail kommt an meine öffentlich einsehbare Adresse. Mach ich bei wichtigeren Dingen eigentlich nicht (mehr dazu später)

Zum Inhalt:

- Subject ist reißerisch und unspezifisch, schreit „Klick mich! Klick mich!“ – das machen Spammer/Scammer/Phisher

- Keine persönliche Anrede. Der Absender kennt mich offenbar nicht – das machen Spammer/Scammer/Phisher (und selbst die schaffen das mittlerweile)

- Es wartet ein unspezifisches wichtiges Dokument auf mich und ich soll einen Link klicken. – das machen Spammer/Scammer/Phisher

Immerhin sind keine Tippfehler drin. Ich habe keine Zeit und lass die Mail ein paar Tage im Postfach liegen um später nochmal in Ruhe draufzuschauen. Einen Link klicke ich natürlich nicht, dafür hat die Mail einfach zu viele rote Flaggen, finde aber in der Browser History die Domain, auf der ich vor einiger Zeit einen Account angelegt habe.

Nach dem Login gibt es dann doch ein wichtiges Dokument, das allerdings nicht ganz so wichtig ist.

Meine zweckspezifischen Mailadressen

Wie vorhin angedeutet, verwende ich für wichtige Dinge spezifische Mailadressen, die den Absender eindeutig markieren. In etwa wie die Plus-Adressierung, wie sie Google Mail oder Outlook unterstützen, nur dass das bei meinem Hoster nicht geht. Also habe ich Mailforwardings mit sehr spezifischen Namen eingerichtet. Um ein fiktives Beispiel zu nennen: Wäre in Kunde bei der „Fischers Fritze“-Bank, würde ich eine Weiterleitung „von_bank_fischersfritze@“ einrichten. Bei Plusadressierung wäre die Variante „chris+fischersfritze@“, ihr versteht den Punkt.

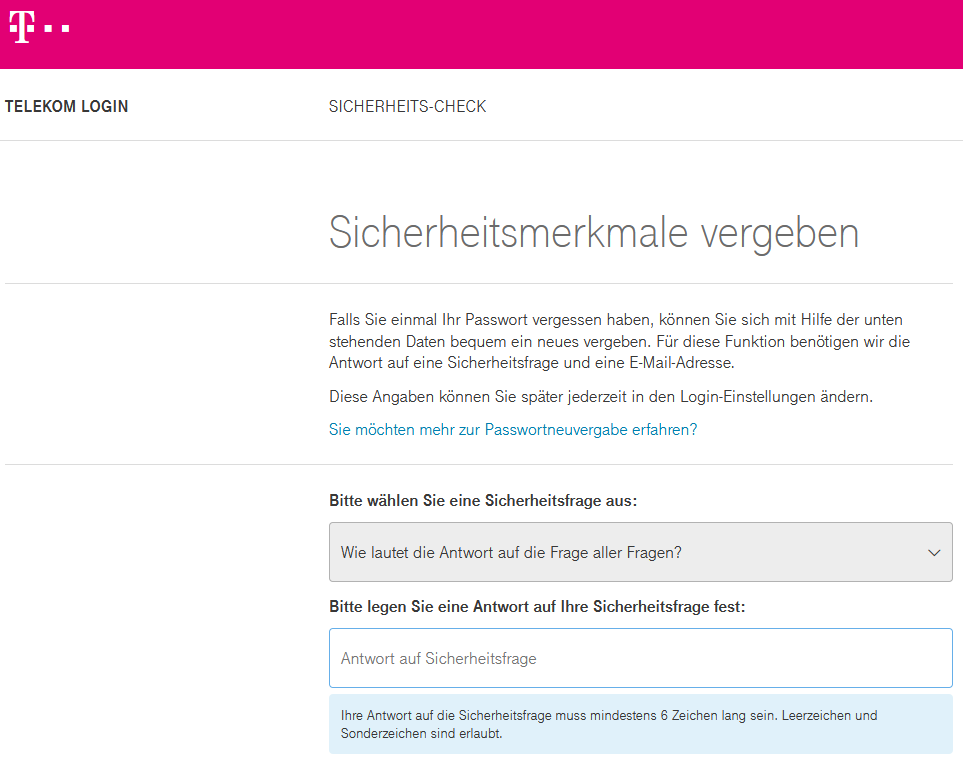

Nach dem Motto: Was nicht passt wird passend gemacht. Also erst einmal das Telefon geholt, per TOTP-2FA (Zwinkersmiley, siehe später) im Hoster-Backend eingeloggt und eine neue Mailweiterleitung angelegt.

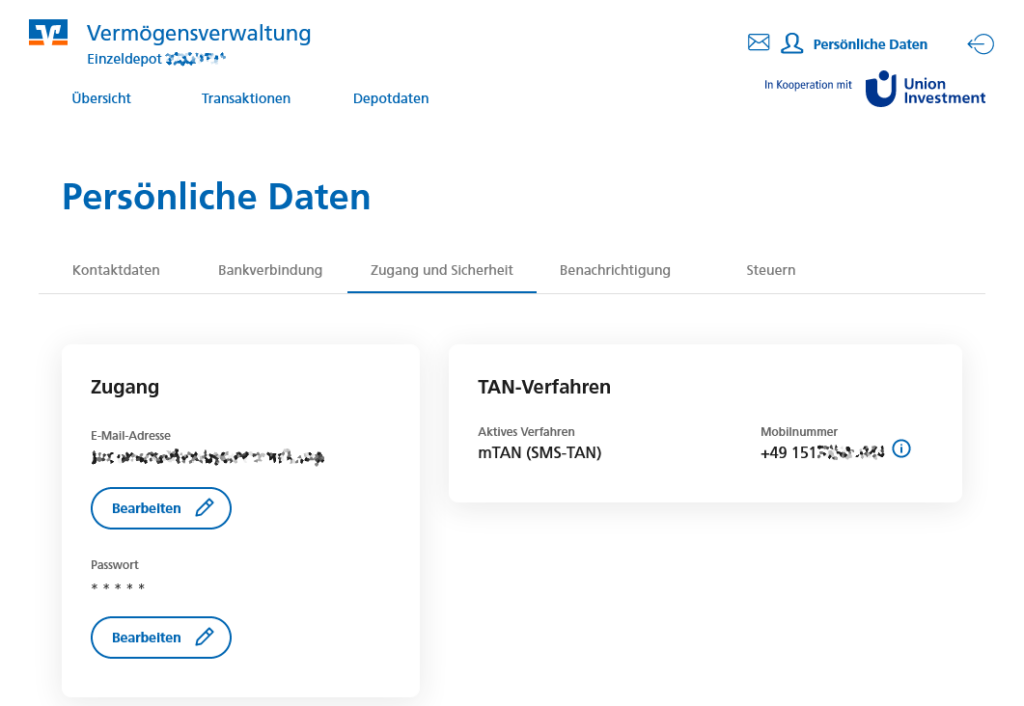

Bei MeinInvest in die persönlichen Daten navigiert, Ernüchterung stellt sich ein:

- Meine vollständigen Kontaktdaten, Geburtsdatum, Steuer-ID, Geburtsort, Staartsangehörigkeit, Bankverbindung und noch dazu Mailadresse sind sichtbar – ok, letztere habe ich auch beim Login eingegeben, also soweit nicht schlimm. Aber der Rest: SPINNT IHR? DAS IST EIN FESTMAHL FÜR IDENTITÄTSDIEBE!

- meine vollständige Mobilnummer für 2FA ist sichtbar – ok. ruhig bleiben. WAS ZUM? Jemand, der eine Session geklaut hat, weiß damit, WAS MEIN VERDAMMTER ZWEITER FAKTOR IST und kann IHN DURCH ANKLINGELN AUCH NOCH BEQUEM STEHLEN – ODER EINFACH ANRUFEN „Hallo hier ist $IhreBank, wir müssen Ihr Konto verifizieren und haben einen Code geschickt, sag mal“! HAT MAN EUCH ALS KINDER DIE MILCH GEGEN LACK AUSGETAUSCHT?

Durchatmen. Es wird hoffentlich nicht schlimmer.

Ich klicke also bei der Mailadresse auf Bearbeiten und tippe meine frisch erstellte Weiterleitungsadresse ein. Ding, schon ist die SMS da:

Die 2FA-SMS

Keine Ahnung, ob da im Template vergessen wurde „IhreBank“ durch den Namen meiner Bank oder zumindest UnionInvestment zu ersetzen (zum Verständnis: Dienst-SMS können mit einem Nummernüberdeckenden Namen gesendet werden, ich hab diesbezüglich nix im Telefonbuch), IMHO etwas ungeschickt ist, dass die TAN so ziemlich als erstes in der SMS steht. Manche Telefone zeigen zumindest einen Anriss von Nachrichten im Lockscreen an – würde die Nachricht gefüllt werden à la „Servus, an Ihrem Account wurde eine Änderung der E-Mail-Adresse vorgenommen, wenn Sie dies durchgeführt und beabsichtigt haben, bestätigen Sie dies bitte mit der folgenden mTAN: 123456“, wäre der Bestätigungscode zumindest bei manchen Telefonen hinter die Entsperrmauer verbannt.

Zugegeben an dieser Stelle: Mein Fehler. Solche Nachrichten sollte man im Sperrbildschirm deaktivieren. Dazu kommt, dass mTAN mittlerweile überholt und durch MultiSIM-Attacken mittlerweile ein leichtes Ziel für Identitätsdiebe ist. Wie wäre es mit modernen Verfahren wie TOTP, was komplett vom User getrieben ist und nicht auf ein verbundenes (und damit angreifbares Gerät) beschränkt ist.

Zähneknirschend gebe ich die mTAN ein und das könnte es gewesen sein.

Die (ausbleibende) Benachrichtigung

Ist es aber nicht.

Kurz darauf trudelt eine E-Mail zur Bestätigung der neuen Mailadresse ein. … auf der neuen Mailadresse. AUF DER NEUEN MAILADRESSE.

An die Alte ging nichts. In Sachen Schadensbegrenzung bei einem Accountdiebstahl ist das – diplomatisch ausgedrückt – nicht sehr vorteilhaft. Man bekommt nicht mit, dass etwas passiert ist. Wohlbemerkt bei einer Geldanlage die tendenziell davon lebt, dass man nicht jede Woche reinschaut.

Also im Zweifel: Account weg, Geld weg und vielleicht noch ein bisschen mehr.

Kontaktaufnahme

Eine security.txt ist bei meininvest.de zwar (nur mit https-Protokoll, HTTP-Status 200) erreichbar, hat aber eine Länge von 0 Byte. So war das nicht gedacht, Leute. Ok, mit www. vor der Domain kommt ein 404. Für eine Bank eher weniger cool. Bei union-investment.de schaut man genauso in die Röhre. Muss ich überhaupt noch erwähnen, dass es auf der Website meiner lokalen Bank ebenfalls keine gibt?

Also manuelle Kontaktsuche. Bei meiner Bankniederlassung gibt es unter Kontakt erst einmal nur ein popeliges Formular. In den Untiefen der Seiten finde ich dann doch noch eine Mailadresse zu einem Ansprechpartner für Kundendialog.

Aufschrieb hin (nicht im Umfang wie hier) und ab dafür. Die Eingangsbestätigung mit Hinweis auf eine Weiterleitung an UI kommt einen Tag später, eine Rückmeldung eine weitere Woche später.

Im Groben war die Antwort: mTAN ist zulässig und sicher, die Sicherheit wird regelmäßig bla-bla-bla. An 2FA wird gearbeitet und es wird geplant noch 2022 einzuführen.

Zur nicht idealen Benachrichtigung per Mail: kein Kommentar, gleiches bzgl. security.txt.

Der Vollständigkeit halber: Das anzeigen der vollständigen Mailadresse und Handynummer habe ich in meiner ersten Mail nicht erwähnt.

Vonseiten der lokalen Bank kam zur security.txt die Anmerkung, dass das aktuell nicht geht, aber es ja ein Impressum und eine Beschwerdeseite gibt. Ideal ist anders, insbesondere weil unnötige Hürden bleiben (z. B. für automatisierte Meldungen oder nicht-deutschsprachigen Forschenden).

Ein kleiner Kommentar in der Antwort hat mich allerdings auf Ideen gebracht: Meine Überweisungen vom Giro auf das Sparbuch hat wohl für Erheiterung gesorgt. Es war vermutlich ein Verwendungszweck wie:

Muss jemand das tatsächlich lesen?Ok,hier etwas für den Wortschatz: Als Gummikavalier wurde in den 1930er Jahren ein Schwimmring bezeichnet

Die nächsten drei Überweisungen sahen dann wie folgt aus:

1/3 Ueberweisungen haben eine Gemeinsamkeit mit dem Internet: Einmal drin, bekommt man Informationen ganz schlecht wieder raus.

2/3 In dem Sinne: Union Investmentlegt bei MeinInvest eher weniger Wert auf Schutz vor Onlinekontodiebstahl. Man bekommt keine Nachricht

3/3 auf die vorherige Mailadresse,dass sie geaendert wurde.Ein entsprechender Hinweis wurde von UI ignoriert. Nachbarschaftliche Gruesse 🙂

Eigentlich hätte ich noch mit dem Einwerfen des Wortes „Sextape“ die manuelle Prüfung triggern sollen. Auch nach etwa 3 Wochen (Zeitpunkt der Erstellung dieses Posts) hat zumindest noch kein Telefon geklingelt.

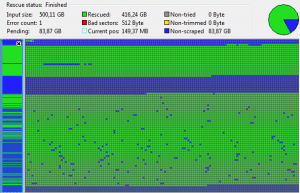

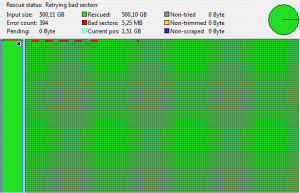

Wo stehen wir nun?

Nach knapp zwei Monaten (Stand 11.09.2022) sieht’s noch wie oben geschildert aus. (Änderung der Mailadresse habe ich allerdings nicht noch einmal getestet)

Nach der erhaltenen Rückmeldung (26.07.2022) könnte sich eigentlich niemand mehr über eine Veröffentlichung beschweren – auch sind die gefundenen Fehler nicht besonders kritisch, bieten aber unnötige Angriffsfläche für Accountdiebstahl und weiteren Missbrauch von verifizierten Daten.

Da sich dieser Aufschrieb jedoch von der ursprünglichen Meldung unterscheidet, habe ich mich für Responsible Disclosure entschieden, also vor der Veröffentlichung eine Möglichkeit zur Reaktion anzubieten.

Eine entsprechende Mail ging am 11.09.2022 mit einer Frist zum 19.09.2022 und dem Angebot einer einmaligen Verzögerung raus. Ja, das ist kurz, mit dem Vorlauf der ursprünglichen Inkenntnissetzung IMHO aber lang genug. Kurz nach dem Versand kam eine OOO-Benachrichtigung mit Rückkehr zum 12.09., bedeutet: Die Mail ist angekommen, und einer rechtzeitigen Reaktion meines Ansprechpartners stand nichts im Wege.

Nachdem auch am 20.09.2022 keine Rückmeldung erfolgte, wurde der Artikel mit leichten Modifikationen (dieser Abschnitt, hinzugefügter Angriffsvektor für 2FA) veröffentlicht.

Mal sehen, ob das Telefon doch noch klingelt.